AI 時代,學術界正被算力餓死

最近看到一組數據,說實在,蠻震驚的。

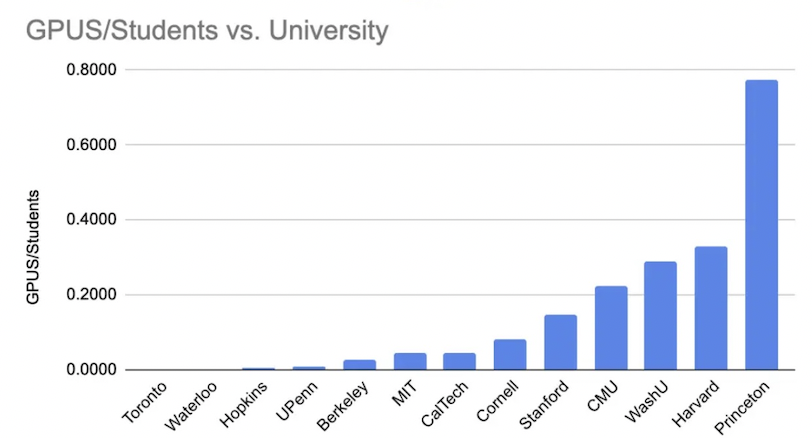

在美國頂尖名校裡,AI 學生的「人均 GPU」只有 0.1 張。

對,你沒看錯,不是 10 張,不是 1 張,是 0.1 張。

具體數字是這樣:

- 普林斯頓: 0.8 張

- 史丹佛: 0.14 張

- MIT / Berkeley: 不到 0.1 張

同一時間,OpenAI、Google、Meta、xAI 都在用「十萬到百萬張」GPU 訓練模型。學界與業界的差距,已經不是一個級別的問題了。就拿微软的 Fairwater Atlanta 数据中心来说,它目前的算力每个月能跑 23 次 GPT-4 规模的训练。

1. 學界不是在做研究,是在排隊用 GPU

AI 大牛 Sebastian Raschka 講了一個很真實的痛點:

「學校 GPU 只能用 SLURM,沒有互動模式,非常折磨。」

什麼意思?就是你不能像在自己電腦上那樣「跑一下、看結果、調參數、再跑」。你得把任務丟進排隊系統,然後等。更誇張的是很多大學 GPU 24 小時就被強制砍掉,你要 checkpoint → 重排隊 → 等三天才能再跑。

有教授說:「這不像研究,更像耐力測試。」沒有足夠的算力,你連「快速試錯」都做不到。而大模型的突破,恰恰就是來自快速試錯、大量實驗、不斷重跑。學界現在的處境,就是被綁著手腳去跟全力衝刺的業界競爭。

不是所有學校都在餓肚子。有些開始認真投資了,舉例 UT Austin: 直接買 4000 張 Blackwell,總 GPU 超過 5000 張,還有一個學校的發電廠供 GPU。但這些都是少數。

在這種環境下,學術界沒有產業數據,也沒有算力,幾乎做不到 frontier AI。

Nature 調查也指出:工業界的算力已完全壓倒學界,學界逐漸失去「定義 AI 方向」的能力。這才是最可怕的。以前,很多突破性的 idea 都是從學界出來的。但現在,如果你沒有算力去驗證一個 idea,那這個 idea 就只能停留在論文裡,等業界有興趣了才會被實現。

學界從「創新引擎」變成「idea 供應商」,這個轉變很微妙,但影響深遠。

如果你是一個想做 frontier AI 的人,你會選哪裡?

工業界: 十萬張 GPU,快速迭代,完整工程團隊,想法能落地,只是你的東西做出來只能優化某個人的短視頻點擊

學界: 0.1 張 GPU,排隊三天,一堆行政限制,想法只能發論文

這不叫選擇,這是現實逼出來的。因為這是結構性問題,不是個別學校或個別學生能改變的。