AI 企業轉型不是導入工具,而是治理問題

目錄

- 為什麼 AI 企業轉型卡關的不是 PPT,而是治理

- AI 企業轉型的三個階段

- AI Agent 的四大治理與資安風險

- 企業真正害怕的不是 AI,而是「不能解釋」

- 沒有 Agent Security,就沒有 AI 企業轉型

- Agent Security 該從哪裡開始?

- 結語

為什麼 AI 企業轉型卡關的不是 PPT,而是治理

我在過去一年接觸了不下數十個企業 AI 專案落地,發現一個很有趣的現象:

Demo 都超厲害,上線都超困難。

這不是技術問題。模型準不準、API 穩不穩,這些都有解。真正卡住的是:

- 沒人敢簽責任:AI 做的決策,出事算誰的?

- 出事不知道怎麼追:模型說 A,結果做了 B,log 在哪裡?

- 資料一出去就回不來:接上知識庫,萬一被注入惡意指令怎麼辦?

這三個問題,技術團隊通常不會主動提,因為這不是他們的 KPI。業務單位也不會問,因為他們不懂。結果就是:大家都在等,沒人敢推上線。

根據 MIT 的《生成式 AI 鴻溝》報告,95% 的企業 AI 專案沒有實質商業回報。但同一份報告也說,80% 的員工私下都在用 ChatGPT。

這說明什麼?AI 不是不能用,是企業不知道怎麼安全地用。

AI 企業轉型的三個階段

企業AI跟數位轉型,大致可以分成三個階段。每個階段有不同的目標和風險。

階段一:對齊高層目標,建立種子團隊

這是最關鍵但最常被跳過的階段。很多企業一開始就想「買工具」、「導入系統」,結果三個月後發現:老闆要的跟 IT 做的完全不一樣。

這個階段的重點:

- 對齊企業高層的 AI 導入目標:不是「我們要用 AI」,而是「AI 要解決什麼問題、創造什麼價值」

- 建立種子團隊:找到願意嘗試、有影響力的內部推動者

- 定義成功指標:怎樣算成功?省多少時間?提升多少效率?

這個階段也會開始導入一些 AI 工具讓種子團隊試用,風險相對低。因為還沒有真正的系統上線,頂多是浪費一些會議時間。

但這裡有一個很容易被忽略的重點:除了對齊業務目標,還要對齊資訊安全目標。

很多企業在這個階段只談「AI 能幫我們做什麼」,沒人問「AI 不能做什麼」、「資料能不能出去」、「出事誰負責」。等到第三階段要規模化時,資安團隊才跳出來說「這個不能上線」,前面的投資全部白費。

如果跳過這個階段,後面所有投資都可能打水漂。這幾乎是成敗的關鍵,我在艾立運能跟台灣家樂福,都有非常詳細的跟高層對焦,才有後面數位轉型的成功。

階段二:快速建立第一個 Agent Quick Win

有了共識和團隊,下一步是快速證明價值。

這個階段的關鍵是「小而快」:

- 選一個痛點明確、範圍可控的場景

- 用最短時間做出一個可用的 Agent

- 讓種子團隊實際使用,收集回饋

特徵:快、爽、建立信心

這個階段的風險開始出現,但還算可控。因為範圍小、用戶少,出問題也容易收拾。

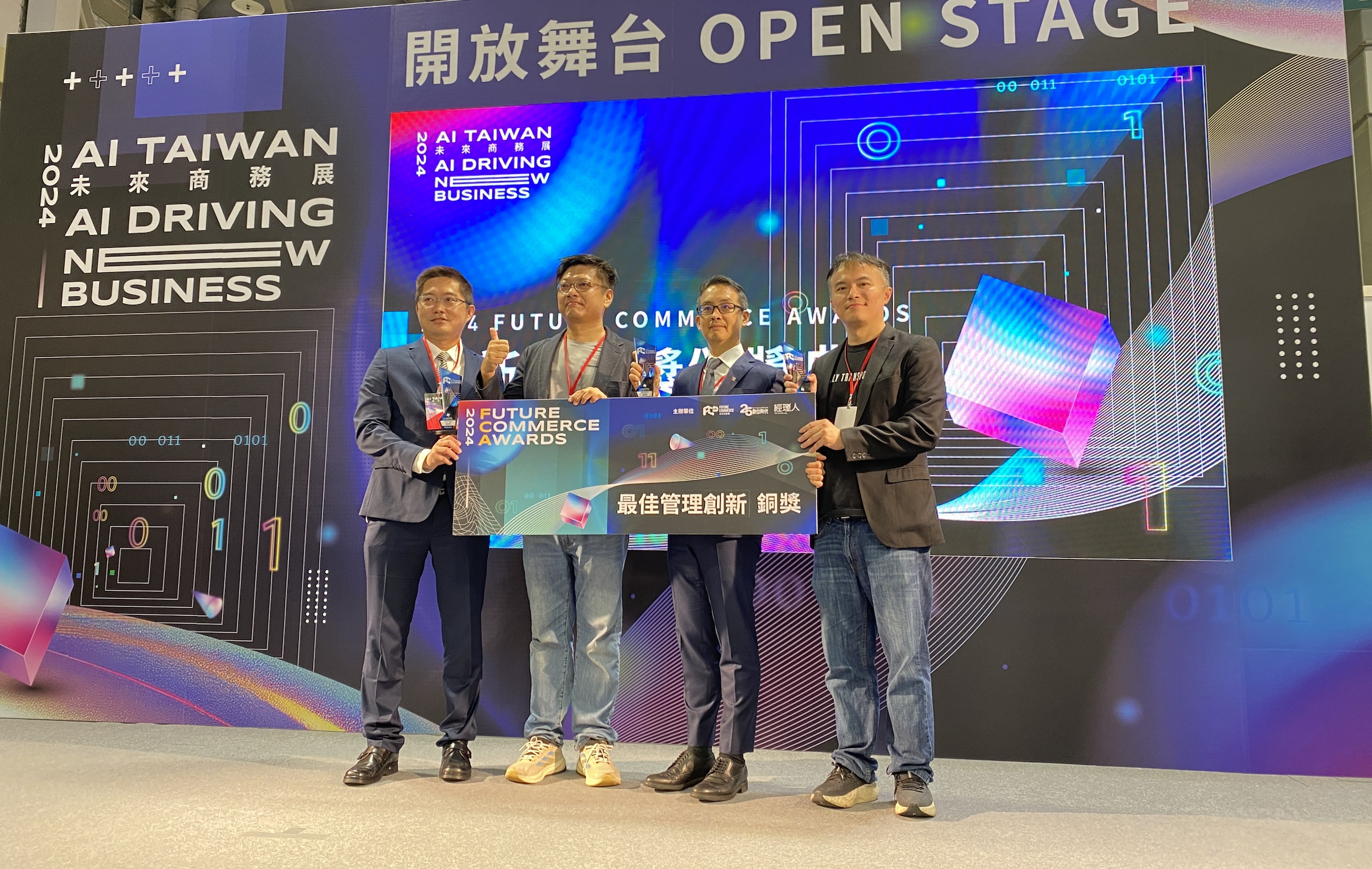

最重要的是:讓高層和團隊看到 AI 真的能解決問題。 這是推動後續投資的關鍵。舉例,像是我在艾立運能做的AI數位回單,就在一個多月就直接上線,因為成效很好,還獲得2024年未來商務展的管理獎。

階段三:Agent 化

當 Quick Win 成功,企業開始想「規模化」。這是關鍵轉折。AI 從「小實驗」變成「核心流程」:

- AI 有目標:不是等你下指令,是主動完成任務

- AI 會規劃:自己決定要做什麼、怎麼做

- AI 會執行:直接呼叫 API、操作資料庫、觸發工作流

企業真正的風險點從這裡開始。

當 AI 有了「代理權」,你授權它做的事情,和它實際做的事情,可能完全不同。這不是理論,這是已經發生的事。

這也是為什麼我認為,AI 企業轉型真正的關鍵不在模型,而在「AI Agent 能不能被安全地治理」。

我在國內數家商業銀行,就做過 Governance 專案和 Security Health Check,才深刻體會:沒有治理框架,Agent 根本不可能進入核心業務流程。

AI Agent 的四大治理與資安風險

Agent 帶來的不是「更聰明」。

Agent 帶來的是:

- 行為不可預期:你沒辦法窮舉所有可能的輸入

- 決策不可回溯:模型為什麼做這個決定?很多時候連開發者都不知道

- 權限可能被放大:一個小小的 prompt injection,可能讓 Agent 存取它不該存取的資料

四個核心風險

我認為 Agent 時代有四大威脅:

1. Prompt Injection(提示注入)

攻擊者在資料中埋入惡意指令。Agent 讀取資料時,被「劫持」去執行攻擊者的命令。

Salesforce 的 Agentforce 就是這樣被攻破的:攻擊者在網頁表單填入惡意指令,AI 銷售助理處理這筆「客戶資料」時,自動把整個客戶名單外傳給攻擊者。

2. Tool Misuse(工具濫用)

Agent 被賦予太多權限,做了超出預期的操作。

OWASP 把這個風險命名為 Excessive Agency(過度代理),列為 LLM 應用的核心風險之一。

3. Memory 污染

Agent 的記憶被污染,導致後續所有決策都基於錯誤的前提。

這在多 Agent 協作場景特別危險。根據研究,100% 的多 Agent 信任鏈場景都能被成功攻破。

4. 資料外洩

Microsoft 365 Copilot 的 EchoLeak 攻擊就是典型案例。攻擊者發一封郵件,Copilot 在背景「幫你」處理時,把你的 SharePoint 財務報告編碼到一個圖片 URL 中,靜靜地送出去。

你什麼都沒做,甚至不知道這封郵件存在,資料已經外洩了。

企業真正害怕的不是 AI,而是「不能解釋」

很多人以為企業不敢用 AI 是因為「怕出錯」。

錯了。

企業真正害怕的是「出錯時沒辦法解釋」。

有 log 不等於可稽核:為什麼企業需要可重播的 Agent 決策

我見過很多 Agent 系統號稱「有完整 log」。打開一看:

1

2

3

2025-12-28 10:00:01 [INFO] Agent received prompt

2025-12-28 10:00:02 [INFO] Agent called tool: database_query

2025-12-28 10:00:03 [INFO] Agent returned response

這叫 log 嗎?這叫垃圾。

我問你:

- Agent 為什麼選擇呼叫這個工具?

- 它考慮過哪些替代方案?

- 如果輸入稍微不同,結果會怎樣?

這些問題,99% 的 Agent 系統都答不出來。

Replay 決策比 Accuracy 更重要

在傳統 ML 時代,我們追求的是 accuracy。模型準不準,看測試集就知道。

在 Agent 時代,accuracy 不夠。你需要的是 可重播性(Replayability)。

同樣的輸入,同樣的上下文,Agent 會不會做出同樣的決策?

如果不行,你怎麼向稽核解釋?怎麼向法務解釋?怎麼向客戶解釋?

Explainability 在 Agent 世界常是假的

很多 Agent 會「解釋」自己的決策。

但那個解釋是 事後編造 的,不是真正的決策過程。

這就像你問一個人「你為什麼選擇這份工作?」他會給你一個聽起來很合理的答案。但真正的原因,可能是他自己都不知道的潛意識偏好。

Agent 的「解釋」也是一樣。它只是在事後合理化,不是真的在告訴你決策過程。

所以我的結論是:AI 企業轉型,本質是治理問題。

不解決治理,技術再好也上不了線。

沒有 Agent Security,就沒有 AI 企業轉型

我在 2025 年 11 月的香港 AWS跟ECV合辦的資訊安全論壇演講中,整理了目前歷歷在目的 Agent 威脅

根據 2025 年 10 月的研究,94.4% 的 SOTA LLM Agent 容易受到 Prompt Injection 攻擊。

這不是「有些 Agent 有漏洞」。

這是「幾乎所有 Agent 都有漏洞」。

而根據 Gartner 預測,到 2028 年,33% 的企業軟體將包含 Agentic AI。相比 2024 年的 <1%,這是 33 倍的成長。

我們的資安武器還沒 Ready,卻正在以 33 倍的速度部署這些系統。

所以我的主張很簡單:

- 沒有 Security,Agent 只能 demo

- 沒有稽核,AI 不能進核心流程

- 沒有治理,轉型只會製造新風險

Agent Security 該從哪裡開始?

如果你是老闆或 CIO,這裡有一份簡單的 checklist。不用懂技術,但你應該問你的團隊這些問題:

1. Agent 有沒有行為邊界?

「這個 Agent 能做什麼、不能做什麼?」

如果答案是「理論上它可以做任何事」,那就是紅旗。

2. Tool 權限怎麼控?

「Agent 呼叫的每個 API,權限是怎麼設的?」

如果 Agent 能存取的資料比一般員工還多,那就是問題。

3. 決策能不能重播?

「如果出了問題,我們能不能回溯 Agent 當時的決策過程?」

如果不行,就別上線。

4. 出事責任算誰的?

這個問題最重要。

「如果 Agent 做了錯誤決策導致損失,法律責任歸屬是誰?」

如果沒人能回答,就代表這個系統沒準備好。

結語:AI 企業轉型不是快慢,而是能不能承擔後果

我見過太多企業急著導入 AI,怕被競爭對手超越。

但我也見過更多企業,導入失敗後陷入更大的困境。

真正成熟的 AI 企業轉型,不是模型多強,而是出事時你能不能說清楚。

這句話,我希望每個正在規劃 AI 轉型的老闆都能記住。

快不是重點。穩才是。

能解釋、能追溯、能負責,這才是 AI 企業轉型的真正門檻。

下一步

如果你對 Agent Security 有興趣,我建議從這幾篇文章開始:

- AI Agent 安全性:遊戲規則已經改變 — 詳細的攻擊案例和數據

- FDE:AI Agent 落地新模式 — 為什麼駐場工程師模式能降低風險

- 流程是一個濾光片 — 沒有領域知識,數據就是雜訊